Campus

Campus

Diagrama de temas

-

Uso de la Biblioteca Accelerate

Introducción a Accelerate para Entrenamiento Distribuido

La biblioteca Accelerate es una herramienta poderosa desarrollada por Hugging Face para simplificar el proceso de entrenamiento distribuido de modelos de aprendizaje profundo. Su objetivo principal es permitir a los investigadores y desarrolladores escalar el entrenamiento de modelos sin la necesidad de realizar modificaciones significativas en su código. Accelerate facilita el uso de múltiples GPUs y múltiples nodos, permitiendo un entrenamiento más rápido y eficiente.

La biblioteca Accelerate se encarga de la gestión de dispositivos, la sincronización de parámetros y la coordinación de tareas entre las distintas GPUs o nodos. Además, ofrece una API intuitiva que hace que la transición de un entorno de entrenamiento con una sola GPU a un entorno distribuido sea fluida y sin complicaciones.

Características Principales de Accelerate

1. Facilidad de Uso: Proporciona una API sencilla y fácil de integrar en el código existente.

2. Flexibilidad: Compatible con varios backends como PyTorch, TensorFlow, y JAX.

3. Escalabilidad: Permite el entrenamiento en múltiples GPUs y nodos sin necesidad de modificaciones extensas en el código.

4. Optimización Automática: Gestiona automáticamente la asignación de dispositivos y la comunicación entre ellos.

Ejemplos de Uso de Accelerate para Control Total sobre el Ciclo de Entrenamiento

Aquí se presentan ejemplos prácticos de cómo utilizar Accelerate para tener control total sobre el ciclo de entrenamiento, desde la inicialización hasta la finalización del proceso.

1. Instalación de Accelerate

Para comenzar, se debe instalar la biblioteca Accelerate utilizando pip:

pip install accelerate

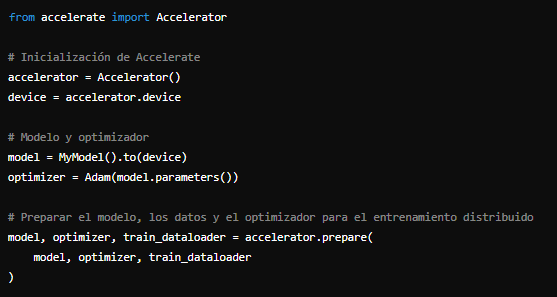

2. Inicialización de Accelerate

3. Ciclo de EntrenamientoSe debe inicializar Accelerate en el script de entrenamiento. Esto configura los dispositivos y prepara el entorno para el entrenamiento distribuido:

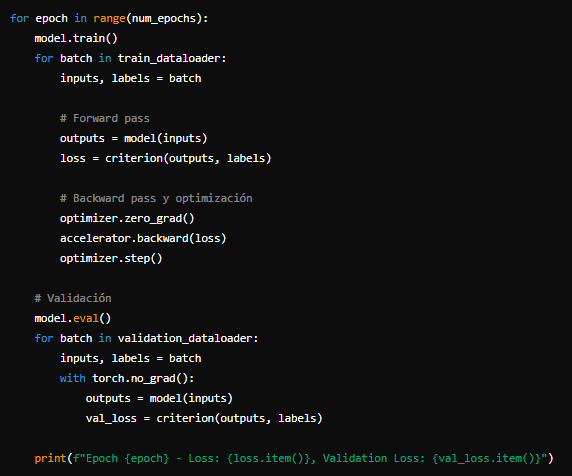

Con Accelerate inicializado, se puede proceder a definir el ciclo de entrenamiento. La biblioteca se encarga de la distribución de datos y sincronización entre dispositivos.

Con Accelerate inicializado, se puede proceder a definir el ciclo de entrenamiento. La biblioteca se encarga de la distribución de datos y sincronización entre dispositivos. 4. Ejecución en Múltiples GPUs

4. Ejecución en Múltiples GPUsPara ejecutar el entrenamiento en múltiples GPUs, se puede utilizar el comando

acceleratedesde la línea de comandos:accelerate launch train.py

Este comando inicia el script de entrenamiento

train.pyen un entorno distribuido, utilizando todas las GPUs disponibles en el sistema.5. Configuración Avanzada

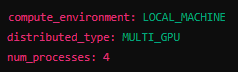

Accelerate permite configuraciones más avanzadas, como el ajuste fino de parámetros de entrenamiento distribuido, mediante un archivo de configuración. Aquí un ejemplo básico de un archivo

`accelerate_config.yaml`:

Luego, se puede inicializar Accelerate con este archivo de configuración:

accelerate config

En resumen, la biblioteca Accelerate de Hugging Face es una herramienta esencial para cualquier investigador o desarrollador que desee escalar el entrenamiento de sus modelos de manera eficiente. Con su API intuitiva y su capacidad para manejar la distribución de tareas y sincronización de datos, Accelerate facilita enormemente el proceso de entrenamiento distribuido, permitiendo a los usuarios centrarse en el desarrollo de sus modelos sin preocuparse por la complejidad del entrenamiento en múltiples GPUs o nodos.