Campus

Campus

Diagrama de temas

-

Codificación Posicional en Transformers

Los Transformers son una arquitectura de red neuronal que ha revolucionado el procesamiento del lenguaje natural (NLP) y otras tareas que requieren la manipulación de secuencias. Una característica clave de los Transformers es su capacidad para procesar secuencias enteras simultáneamente, en lugar de procesarlas elemento por elemento. Sin embargo, este enfoque introduce un desafío: la pérdida de información sobre el orden de las palabras. Para solucionar este problema, los Transformers emplean una técnica llamada codificación posicional (Positional Encoding).

Concepto y Necesidad de la Codificación Posicional

Concepto

La codificación posicional es una técnica utilizada para incorporar información sobre la posición de cada elemento en la secuencia dentro del modelo Transformer. Dado que los Transformers procesan todos los elementos de la secuencia en paralelo, no tienen una forma inherente de saber el orden de estos elementos. La codificación posicional resuelve este problema al añadir información sobre la posición relativa de cada palabra o elemento en la secuencia.

Necesidad

1. Preservar el Orden Secuencial: En tareas de NLP, el significado de una oración puede depender en gran medida del orden de las palabras. Sin una manera de representar este orden, los Transformers no podrían captar completamente el contexto y las relaciones entre las palabras.

2. Mejorar la Interpretación de Datos: La codificación posicional permite al modelo distinguir entre elementos que pueden tener el mismo valor pero que aparecen en diferentes posiciones, mejorando así la interpretación de la secuencia completa.

Implementación de la Codificación Posicional

La codificación posicional se implementa de manera que se suma directamente a las embeddings de las palabras antes de pasarlas a la capa de atención del Transformer. Aquí se describen los detalles de cómo se realiza esta implementación:

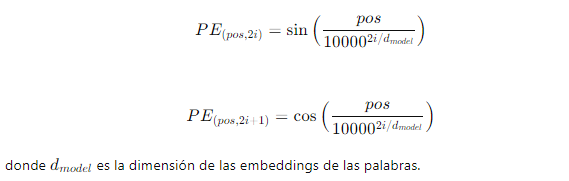

1. Fórmula Matemática: Las codificaciones posicionales se calculan utilizando funciones trigonométricas (seno y coseno) para cada posición pos en la secuencia y cada dimensión i en la embedding:

2.

Generación de Codificaciones: Para cada posición en la secuencia, se genera un vector de codificación posicional de la misma dimensión que las embeddings de las palabras. Este vector se suma a la embedding de la palabra correspondiente:

Embedding final=Embedding de palabra+Codificación posicional

3. Ejemplo Visual: En la imagen a continuación, se ilustra cómo las codificaciones posicionales se añaden a las embeddings de las palabras en una secuencia. Cada palabra en la entrada tiene una embedding y una codificación posicional correspondiente. Estas se suman para producir las embeddings finales que se pasan al Transformer.

En resumen, la codificación posicional es un componente esencial en los modelos Transformers, permitiendo que estos modelos mantengan la información de orden secuencial mientras procesan todas las posiciones simultáneamente. Al añadir codificaciones posicionales a las embeddings de las palabras, los Transformers pueden interpretar correctamente la estructura de las secuencias, lo que mejora significativamente su rendimiento en tareas de procesamiento del lenguaje natural y otras aplicaciones basadas en secuencias.