Campus

Campus

Diagrama de temas

-

Métodos de Regularización Basados en la Complejidad del Modelo

La regularización es una técnica esencial en el aprendizaje automático que ayuda a prevenir el sobreajuste (overfitting) y mejora la capacidad de generalización de los modelos. Entre los métodos de regularización más importantes se encuentran aquellos basados en la complejidad del modelo, los cuales penalizan modelos complejos para fomentar soluciones más simples y generalizables. En este texto, exploraremos dos enfoques principales: la penalización de normas y la regularización basada en la complejidad de la estructura, así como su aplicación en modelos jerárquicos y árboles de decisión.

Penalización de Normas

La penalización de normas es una técnica de regularización que introduce un término de penalización en la función de costo del modelo, basado en las normas de los parámetros del modelo. Las normas L1 y L2 son las más comunes, y también se pueden combinar para obtener beneficios adicionales.

Regularización Basada en la Norma del Modelo

1. Norma L1 (Lasso):

- Descripción: La regularización L1 añade una penalización proporcional a la suma de los valores absolutos de los pesos del modelo. Esto puede llevar a que algunos pesos se reduzcan a cero, promoviendo la esparsidad en el modelo.

- Fórmula:

C′ = C+λ∑∣w∣

donde es la función de costo original, es el parámetro de regularización y son los pesos del modelo.

- Ventajas: La esparsidad resultante puede ser útil para la selección de características y para interpretar el modelo, ya que elimina características irrelevantes.

2. Norma L2 (Ridge):

- Descripción: La regularización L2 añade una penalización proporcional a la suma de los cuadrados de los pesos del modelo, lo que fuerza a los pesos a mantenerse pequeños.

- Fórmula:

C ′ = C + λ 2 ∑ w 2 Ventajas: Ayuda a prevenir el sobreajuste al controlar la magnitud de los pesos, manteniendo todos los parámetros pero con valores más pequeños y estables.

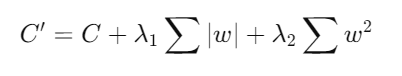

3. Combinación de Normas L1 y L2 (Elastic Net):

- Descripción: La regularización Elastic Net combina las penalizaciones L1 y L2 para aprovechar los beneficios de ambas técnicas.

- Fórmula:

donde y son los parámetros de regularización para las normas L1 y L2, respectivamente.

Ventajas: Combina la esparsidad de Lasso con la estabilidad de Ridge, resultando en modelos más robustos y generalizables.

Regularización Basada en la Complejidad de la Estructura

La regularización basada en la complejidad de la estructura se enfoca en la forma y la complejidad interna del modelo. Este enfoque es particularmente útil en modelos jerárquicos y árboles de decisión.

Aplicación en Modelos Jerárquicos

- Modelos Jerárquicos:

- Descripción: Los modelos jerárquicos capturan relaciones entre variables en diferentes niveles de abstracción. La regularización en estos modelos puede involucrar la penalización de la complejidad de las dependencias entre niveles.

- Técnicas: Métodos como la regularización bayesiana y la selección de modelos jerárquicos pueden ayudar a simplificar la estructura del modelo y mejorar su capacidad de generalización.

Aplicación en Árboles de Decisión

Árboles de Decisión:

- Descripción: Los árboles de decisión son modelos de aprendizaje automático que segmentan los datos en subconjuntos basados en reglas de decisión. Sin regularización, los árboles de decisión tienden a sobreajustarse a los datos de entrenamiento.

- Técnicas de Regularización:

- Poda de Árboles: La poda de árboles reduce la complejidad del árbol eliminando ramas que tienen un impacto mínimo en la precisión de la predicción.

- Penalización de la Profundidad: Limitar la profundidad máxima del árbol ayuda a prevenir el sobreajuste, forzando al modelo a tomar decisiones basadas en características más generales.

Importancia de la RegularizaciónLa regularización es fundamental para desarrollar modelos que no solo se ajusten bien a los datos de entrenamiento, sino que también generalicen bien a datos no vistos. Al introducir penalizaciones basadas en la complejidad del modelo, se promueve la simplicidad y se evita que el modelo se ajuste a las particularidades y el ruido del conjunto de datos de entrenamiento. Esto resulta en modelos más robustos y precisos en diversas aplicaciones del mundo real.

Enlace Adicional

Para más información, acceda a este sitio.