Entrenamiento de Redes Neuronales

El entrenamiento de redes neuronales es un proceso crucial en el campo del aprendizaje automático y la inteligencia artificial. Este proceso permite a las redes neuronales aprender a realizar tareas específicas, como la clasificación de imágenes, el reconocimiento de voz o la predicción de series temporales, a partir de datos de entrenamiento. A través del ajuste de los pesos sinápticos internos, las redes neuronales pueden optimizar su rendimiento y minimizar los errores en sus predicciones. En este texto, exploraremos tres componentes fundamentales del entrenamiento de redes neuronales: el problema del aprendizaje supervisado, el algoritmo de retropropagación y la función de costo.

El Problema del Aprendizaje Supervisado

El aprendizaje supervisado es un tipo de aprendizaje automático en el cual una red neuronal es entrenada utilizando un conjunto de datos etiquetados. Cada dato en el conjunto de entrenamiento consiste en una entrada y una etiqueta correspondiente que representa el resultado deseado. El objetivo de la red es aprender una función que mapea las entradas a las salidas correctas. A continuación se describen los pasos del proceso de aprendizaje supervisado:

1. Recolección de Datos: Se compila un conjunto de datos de entrenamiento compuesto por pares de entrada y salida (x, y), donde x representa las características del dato y y es la etiqueta correspondiente.

2. Inicialización de la Red: Los pesos de las conexiones en la red neuronal se inicializan aleatoriamente.

3. Propagación hacia Adelante (Forward Propagation): Los datos de entrada se pasan a través de la red, capa por capa, hasta obtener una predicción de salida.

4. Cálculo del Error: Se calcula la diferencia entre la predicción de la red y la etiqueta verdadera utilizando una función de costo.

5. Ajuste de Pesos (Backpropagation): Se utilizan algoritmos de optimización para ajustar los pesos de la red de manera que el error se minimice.

Algoritmo de Retropropagación (Backpropagation)

El algoritmo de retropropagación es una técnica esencial utilizada para ajustar los pesos de la red neuronal durante el entrenamiento. Este algoritmo optimiza los pesos mediante el cálculo del gradiente de la función de costo con respecto a cada peso, y luego ajusta los pesos en la dirección opuesta a este gradiente. Los pasos del algoritmo de retropropagación son:

1. Propagación hacia Adelante: Como se describió anteriormente, los datos de entrada se pasan a través de la red para obtener la predicción de salida.

2. Cálculo del Error: Se calcula el error de predicción utilizando la función de costo.

3. Propagación hacia Atrás:

- Cálculo del Gradiente: Se calcula el gradiente de la función de costo con respecto a cada peso utilizando la regla de la cadena. Esto implica calcular las derivadas parciales de la función de costo con respecto a las salidas de cada nodo, luego con respecto a las entradas de cada nodo y finalmente con respecto a los pesos.

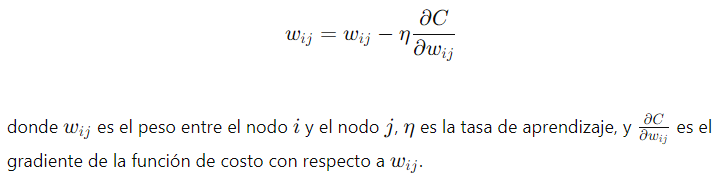

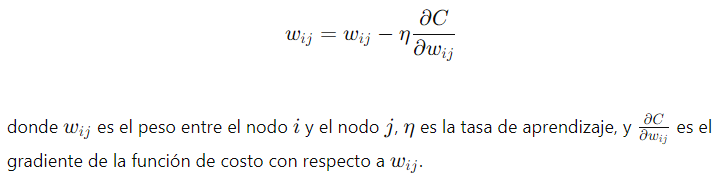

- Actualización de Pesos: Los pesos se ajustan en función del gradiente calculado y una tasa de aprendizaje, siguiendo la fórmula:

Función de Costo

La función de costo, también conocida como función de pérdida o error, es una medida que cuantifica el error entre las predicciones de la red neuronal y las etiquetas verdaderas del conjunto de datos de entrenamiento. El objetivo del entrenamiento es minimizar esta función de costo. Algunas funciones de costo comunes incluyen:

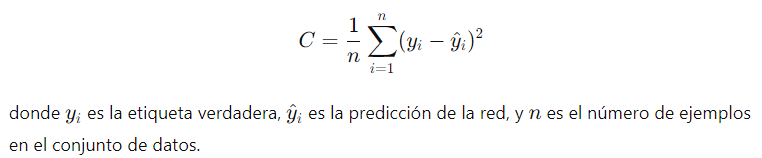

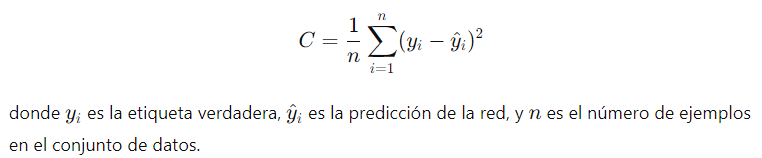

1. Error Cuadrático Medio (MSE):

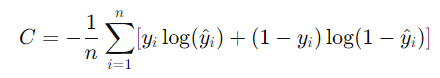

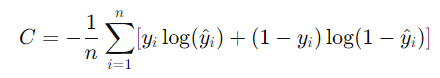

2. Entropía Cruzada (Cross-Entropy):

Esta función de costo es comúnmente utilizada en problemas de clasificación.

El uso de una función de costo adecuada es crucial para el éxito del entrenamiento de la red neuronal, ya que guía el proceso de optimización de los pesos hacia la minimización del error.

Estos componentes son fundamentales para entender cómo se entrenan las redes neuronales y cómo pueden aprender a realizar tareas específicas a partir de datos etiquetados.

Enlace Adicional

Para más información Consulte este sitio.

Campus

Campus