Redes Neuronales Recurrentes (RNN)

¿Qué son las Redes Neuronales Recurrentes (RNN)?

Las Redes Neuronales Recurrentes (RNN) son un tipo de red neuronal diseñada para procesar secuencias de datos. A diferencia de las redes neuronales tradicionales, que asumen que todas las entradas son independientes entre sí, las RNN tienen conexiones cíclicas que les permiten mantener información sobre las entradas anteriores. Esto las hace ideales para tareas donde el contexto y el orden de los datos son importantes, como el procesamiento de texto, la traducción de idiomas y el reconocimiento de voz.

Estructura de una RNN

La característica distintiva de una RNN es su capacidad para mantener una "memoria" de las entradas anteriores a través de sus conexiones recurrentes. Cada unidad en una RNN no solo toma en cuenta la entrada actual, sino también su propio estado anterior, lo que permite que la red retenga información a lo largo del tiempo.

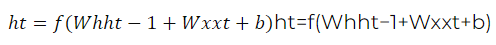

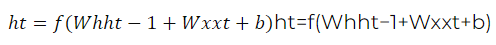

Una RNN típica se compone de capas de neuronas donde cada neurona recibe una entrada y el estado de la neurona en el tiempo anterior. Esta estructura se puede representar matemáticamente como:

donde:

Propagación hacia atrás a través del tiempo (BPTT)

El entrenamiento de una RNN se realiza mediante un proceso llamado Propagación hacia atrás a través del tiempo (BPTT). Este es un método de retropropagación que tiene en cuenta las dependencias temporales de las secuencias. La idea es descomponer el cálculo de los gradientes a través del tiempo y ajustar los pesos de la red para minimizar el error en cada paso de la secuencia.

Problemas de las RNN

Aunque las RNN son poderosas, enfrentan varios desafíos:

1. Desvanecimiento del Gradiente: Durante la BPTT, los gradientes pueden disminuir exponencialmente, lo que dificulta que la red aprenda dependencias a largo plazo.

2. Explosión del Gradiente: Los gradientes pueden crecer exponencialmente, llevando a actualizaciones de pesos inestables.

Para abordar estos problemas, se han desarrollado variantes de RNN, como LSTM (Long Short-Term Memory) y GRU (Gated Recurrent Unit).

LSTM y GRU

LSTM: Las redes LSTM son una versión mejorada de las RNN diseñadas para manejar dependencias a largo plazo. Incorporan "celdas de memoria" que pueden mantener información durante períodos prolongados y mecanismos de "puertas" que controlan el flujo de información dentro y fuera de estas celdas. Las principales componentes de LSTM son:

- Puerta de Entrada: Controla la cantidad de nueva información que se almacena en la celda.

- Puerta de Olvido: Decide cuánta información previa se retiene.

- Puerta de Salida: Determina cuánto de la información de la celda se utiliza para generar la salida.

GRU: Las GRU son similares a las LSTM pero con una estructura más simple. Tienen menos parámetros y son más rápidas de entrenar, aunque son igualmente efectivas en muchos casos. Las GRU combinan la puerta de entrada y la puerta de olvido en una sola "puerta de actualización" y utilizan una "puerta de reinicio" para controlar el flujo de información.

Aplicaciones de las RNN

Las RNN y sus variantes se utilizan en una amplia gama de aplicaciones, incluyendo:

- Procesamiento de Lenguaje Natural (NLP): Traducción automática, generación de texto, análisis de sentimiento.

- Reconocimiento de Voz: Convertir el habla en texto.

- Predicción de Series Temporales: Pronósticos financieros, predicción del clima.

- Video y Visión por Computadora: Análisis de secuencias de video, reconocimiento de gestos.

Las Redes Neuronales Recurrentes son una herramienta poderosa para procesar datos secuenciales y contextuales. A pesar de sus desafíos, las variantes como LSTM y GRU han mejorado significativamente su rendimiento, permitiendo aplicaciones avanzadas en diversas áreas tecnológicas. Entender su funcionamiento básico y sus aplicaciones prácticas es fundamental para aprovechar al máximo estas tecnologías en el campo de la inteligencia artificial y el aprendizaje profundo.

Enlace Adicional:

Para más información visite este sitio.

Campus

Campus